Δέκα μήνες νωρίτερα, αντίστοιχες ανησυχίες είχαν εκφραστεί και στο εσωτερικό της Microsoft από ειδικούς σε θέματα ηθικής και υπαλλήλους άλλων τμημάτων. Σε διάφορα έγγραφα υπογραμμιζόταν πως η τεχνολογία A.I. πίσω από ένα chatbot θα μπορούσε να «πλημμυρίσει» τις ομάδες του Facebook με παραπληροφόρηση, να υποβαθμίσει την κριτική σκέψη, ακόμα και να διαβρώσει τα θεμέλια της σύγχρονης κοινωνίας.

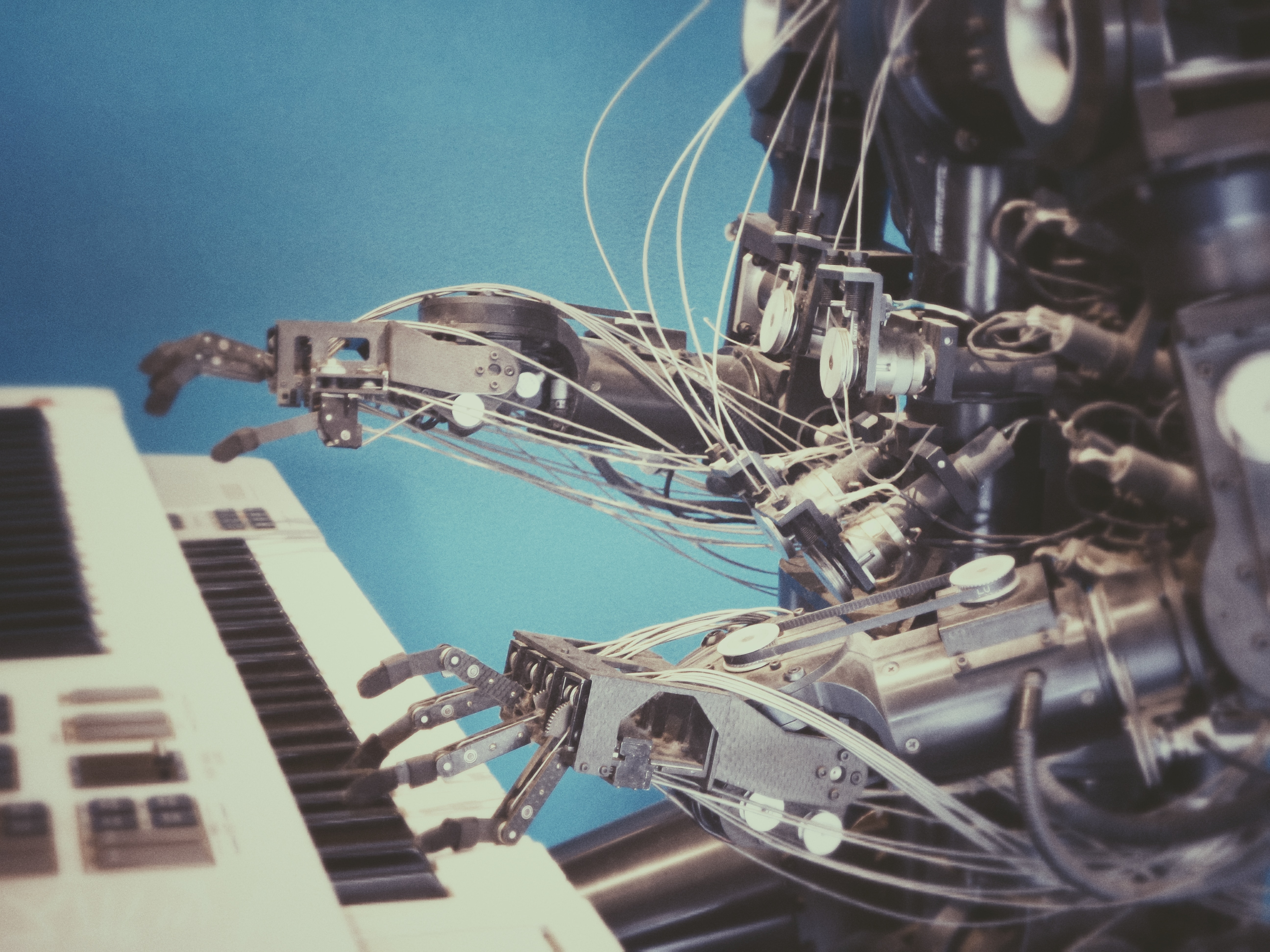

Τελικώς και οι δύο τεχνολογικοί κολοσσοί κυκλοφόρησαν τα chatbots τους. Η Microsoft το παρουσίασε πρώτη, σε μια μεγάλη εκδήλωση τον Φεβρουάριο, αποκαλύπτοντας τον συνδυασμό ενός Α.Ι. chatbot με τη μηχανή αναζήτησης Bing. Η Google ακολούθησε περίπου έξι εβδομάδες αργότερα με το δικό της chatbot, το Bard.

«Οι επιθετικές κινήσεις από εταιρείες που συνήθως αποφεύγουν το ρίσκο καθοδηγήθηκαν από έναν αγώνα δρόμου για τον έλεγχο μιας τεχνολογίας, που θα μπορούσε να είναι “το επόμενο μεγάλο βήμα” της βιομηχανίας: τα συστήματα τεχνητής νοημοσύνης» σημειώνουν οι NYT.

Ο ανταγωνισμός επιταχύνθηκε με ξέφρενο ρυθμό τον Νοέμβριο, όταν η OpenAI, μια νεοσύστατη εταιρεία από το Σαν Φρανσίσκο στην οποία η Microsoft επενδύει δισεκατομμύρια, κυκλοφόρησε το ChatGPT, ένα chatbot τεχνητής νοημοσύνης που, μέσα σε λίγους μήνες, έσπασε το ρεκόρ εξάπλωσης, προσελκύοντας 100 εκατομμύρια χρήστες από όλο τον κόσμο πιο γρήγορα από το TikTok.

Η θολή γραμμή της ηθικής

Η εντυπωσιακή επιτυχία του ChatGPT εξώθησε τη Microsoft και τη Google να πάρουν μεγαλύτερα ρίσκα σε ό,τι αφορά τις κατευθυντήριες γραμμές ηθικής, οι οποίες έχουν θεσπιστεί σε βάθος ετών για να διασφαλίσουν ότι η τεχνολογία δεν θα προκαλέσει κοινωνικά προβλήματα, σύμφωνα με 15 νυν και πρώην υπαλλήλους και εσωτερικά έγγραφα των εταιρειών που επικαλούνται οι NYT.

Το αίσθημα «κατεπείγοντος» στην ανάπτυξη εφαρμογών με τεχνητή νοημοσύνη αποτυπώνεται σε ένα εσωτερικό μήνυμα που έστειλε τον περασμένο μήνα ο Σαμ Σίλαϊς, στέλεχος του τομέα τεχνολογίας στη Microsoft. Όπως έγραφε στο email, το οποίο διάβασαν δημοσιογράφοι των New York Times, θα ήταν «απολύτως μοιραίο λάθος αυτή τη στιγμή να ανησυχούμε για πράγματα που μπορούν να διορθωθούν αργότερα».

Όταν η τεχνολογική βιομηχανία μετατοπίζεται ξαφνικά προς ένα νέο είδος τεχνολογίας, η πρώτη εταιρεία που θα παρουσιάσει ένα προϊόν «θα αναδειχθεί μακροπρόθεσμα νικήτρια μόνο και μόνο επειδή ξεκίνησε πρώτη», έγραψε. «Μερικές φορές η διαφορά είναι μόλις εβδομάδες».

Πριν περίπου δύο εβδομάδες, το ζήτημα των δυνητικών κινδύνων των Α.Ι. επανήλθε στη δημόσια σφαίρα, όταν περισσότεροι από 1.000 ερευνητές και ηγετικές μορφές του τεχνολογικού κλάδου, μεταξύ των οποίων ο Ελον Μασκ και ο συνιδρυτής της Apple Στιβ Βόνιακ, ζήτησαν εξάμηνη «παύση» στην ανάπτυξη μιας ισχυρής τεχνολογίας Α.Ι.. Σε δημόσια επιστολή τους, ανέφεραν η τεχνολογία αυτή θα μπορούσε να συνοδευτεί από «σοβαρότατους κινδύνους για την κοινωνία και την ανθρωπότητα».

Οι ρυθμιστικές αρχές διαμηνύουν πως θα παρέμβουν. Η Ευρωπαϊκή Ένωση πρότεινε ρυθμιστικό πλαίσιο για την τεχνητή νοημοσύνη και η Ιταλία απαγόρευσε προσωρινά το ChatGPT. Στις Ηνωμένες Πολιτείες, ο πρόεδρος Μπάιντεν έγινε την Τρίτη ο τελευταίος ηγέτης που αμφισβητεί ανοιχτά την ασφάλεια των Α.Ι.

«Οι τεχνολογικές εταιρίες έχουν την ευθύνη να βεβαιώνονται ότι τα προϊόντα τους είναι ασφαλή προτού τα κυκλοφορήσουν», δήλωσε από τον Λευκό Οίκο. Ερωτηθείς αν η Τεχνητή Νοημοσύνη είναι επικίνδυνη, απάντησε: «Μένει να το δούμε. Θα μπορούσε να είναι».

«Ούτε οι προγραμματιστές των Α.Ι δεν τα καταλαβαίνουν πλήρως»

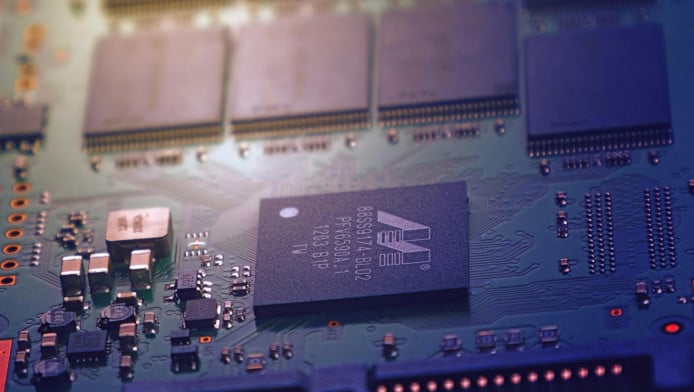

Ερευνητές λένε ότι η Microsoft και η Google παίρνουν ρίσκο με το να λανσάρουν μία τεχνολογία που ακόμη και οι προγραμματιστές πίσω από την ανάπτυξή της δεν την κατανοούν πλήρως.

Η Google κυκλοφόρησε το Bard μετά από χρόνια εσωτερικών διαφωνιών σχετικά με το αν τα οφέλη των Α.Ι. υπερτερούν των κινδύνων. Το 2020 είχε ανακοινώσει τη Meena, ένα παρόμοιο chatbot, αλλά αυτό το σύστημα κρίθηκε πολύ επικίνδυνο για να κυκλοφορήσει, δήλωσαν τρία άτομα με γνώση της υπόθεσης. Οι ανησυχίες αυτές αποκαλυφθεί νωρίτερα από την Wall Street Journal.

Η Google ήταν ενήμερη

Την ίδια χρονιά, η Google παρεμπόδισε δύο από τις κορυφαίες ερευνήτριές της σε ζητήματα ηθικής και τεχνητής νοημοσύνης, τις Τίνιτ Γκέμπρου και Μάργκαρετ Μίτσελ, από το να δημοσιεύσουν μια εργασία που προειδοποιούσε ότι τα μεγάλα γλωσσικά μοντέλα που χρησιμοποιούνται στα νέα συστήματα Α.Ι, θα μπορούσαν να εξαπολύσουν υβριστική γλώσσα.

Οι ερευνήτριες απομακρύνθηκαν αφότου η Δρ. Γκέμπρου επέκρινε τις επιδόσεις της εταιρείας σεό,τι αφορά συμπερίληψη και η Δρ. Μίτσελ κατηγορήθηκε για παραβίαση του κώδικα δεοντολογίας της εταιρείας, όταν αποθήκευσε ορισμένα μηνύματα ηλεκτρονικού ταχυδρομείου της δουλειάς της σε προσωπικό λογαριασμό στο Google Drive.

Οι ανησυχίες παρέμειναν. Τον Ιανουάριο του 2022, η Google προσπάθησε να αποτρέψει έναν άλλο ερευνητή, τον Δρ. Ελ Μαχντί, από το να δημοσιεύσει μια επικριτική μελέτη, σύμφωνα με τους NYT.

Ο Δρ. Μαχντί, καθηγητής πανεπιστημίου, χρησιμοποίησε μαθηματικά θεωρήματα για να προειδοποιήσει ότι τα μεγαλύτερα μοντέλα Α.Ι. είναι πιο ευάλωτα σε επιθέσεις κυβερνοασφάλειας και συνοδεύονται από ασυνήθιστους κινδύνους για την προστασία της ιδιωτικής ζωής, επειδή πιθανότατα είχαν πρόσβαση σε ιδιωτικά δεδομένα που ήταν αποθηκευμένα σε διάφορους ιστότοπους στο διαδίκτυο.

Αν και μια παρουσίαση σε στελέχη της εταιρίας προειδοποιούσε για σχετικές παραβιάσεις της ιδιωτικής ζωής, η Google ζήτησε από τον Δρ. Ελ Μαχντί να κάνει σημαντικές αλλαγές στην έκθεσή του. Εκείνος αρνήθηκε και δημοσίευσε ατόφια την εργασία μέσω της École Polytechnique. Διέκοψε τη συνεργασία του με την Google εκείνη την χρονιά, καταγγέλλοντας «λογοκρισία της έρευνάς» του. Κατά τον ίδιο, οι κίνδυνοι της σύγχρονης τεχνητής νοημοσύνης ξεπερνούσαν κατά πολύ τα οφέλη. «Είναι πρόωρη η ανάπτυξη», σχολίασε.

Μετά την κυκλοφορία του ChatGPT, ο Κεντ Γουόκερ, ο επικεφαλής του νομικού τμήματος της Google, συναντήθηκε με στελέχη των τμημάτων έρευνας και ασφάλειας του ισχυρού Συμβουλίου Αξιολόγησης Προηγμένης Τεχνολογίας της εταιρείας. Τους είπε ότι ο Σούνταρ Πιτσάι, ο διευθύνων σύμβουλος της Google, πίεζε πολύ για την κυκλοφορία της τεχνολογίας Τεχνητής Νοημοσύνης του τεχνολογικού «γίγαντα».

Η Τζεν Τζενάι, διευθύντρια της ομάδας «Υπεύθυνης Καινοτομίας» της Google, συμμετείχε σε αυτή τη συνάντηση. Η ίδια θυμάται ότι ο Γουόκερ ζήτησε από τους παρευρισκόμενους να επισπεύσουν τα πρότζεκτ τεχνητής νοημοσύνης. Ορισμένα στελέχη ξεκαθάρισαν ότι θα τηρήσουν τα πρότυπα ασφαλείας, σύμφωνα με την Τζενάι.

Το Μάρτιο, δύο μέλη της ομάδα της Τζενάι υπέβαλαν την αξιολόγηση κινδύνου για το σύστημα Bard, συστήνοντας να μην κυκλοφορήσει άμεσα, σύμφωνα με δύο άτομα με γνώση της διαδικασίας. Παρά τις δικλείδες ασφαλείας, πίστευαν ότι το chatbot δεν ήταν έτοιμο. Η Τζενάι παρενέβη στο έγγραφο, αφαίρεσε τη σύσταση και υποβάθμισε τη σοβαρότητα των κινδύνων του Bard, σύμφωνα με πηγές των NYT.

Η Microsoft δεν ακολούθησε με συνέπεια τους κανόνες

Ο Σάτια Ναντέλα, διευθύνων σύμβουλος της Microsoft, πίστεψε στα συστήματα Α.Ι. το 2019 και η Microsoft επένδυσε ένα δισεκατομμύριο δολάρια στην OpenAI. Το περασμένο καλοκαίρι, έκρινε ότι η τεχνολογία ήταν έτοιμη και πίεσε κάθε ομάδα προϊόντων της Microsoft να «υιοθετήσει» την Τεχνητή Νοημοσύνη.

Το γραφείο Υπεύθυνης Τεχνητής Νοημοσύνης της Microsoft έχει καθορίσει σχετικούς κανόνες και πολιτικές, αλλά οι κατευθυντήριες γραμμές δεν εφαρμόστηκαν ή δεν ακολουθήθηκαν με συνέπεια, δήλωσαν πέντε νυν και πρώην εργαζόμενοι στην αμερικανική εφημερίδα.

Παρότι υπήρχε η αρχή της διαφάνειας, οι εμπειρογνώμονες δεοντολογίας που αξιολογούσαν chatbot δεν έλαβαν απαντήσεις σχετικά με το ποια δεδομένα χρησιμοποίησε η OpenAI για να αναπτύξει τα συστήματά της, σύμφωνα με τρία άτομα που συμμετείχαν στις εργασίες. Ορισμένοι υποστήριξαν ότι η ενσωμάτωση των chatbots σε μια μηχανή αναζήτησης ήταν μια ιδιαίτερα κακή ιδέα, δεδομένου ότι μερικές φορές δίνονταν αναληθείς λεπτομέρειες, σύμφωνα με άτομο με άμεση γνώση των επίμαχων συνομιλιών.

Το φθινόπωρο, η Microsoft άρχισε να διαλύει μια από τις μεγαλύτερες ομάδες της για την δεοντολογία της τεχνολογίας. Η ομάδα, «Ηθική και Κοινωνία», εκπαίδευε και συμβούλευε τους επικεφαλής των προϊόντων της εταιρείας ώστε αυτά να σχεδιάζονται και να κυκλοφορούν με υπευθυνότητα. Τον Οκτώβριο, τα περισσότερα μέλη της ομάδας μετακινήθηκαν σε άλλες ομάδες, σύμφωνα με τέσσερα άτομα που γνωρίζουν την εσωτερική της δομή.

Οι λίγοι που απέμειναν, συμμετείχαν σε καθημερινές συναντήσεις με την ομάδα του Bing, κάνοντας αγώνα δρόμου για την κυκλοφορία του chatbot. Ο Τζον Μοντγκόμερι, ένα στέλεχος του τμήματος A.I., τους έγραψε σε ένα email, τον περασμένο Δεκέμβριο, ότι η δουλειά τους παρέμενε ζωτικής σημασίας και πως περισσότερες ομάδες θα χρειάζονταν τη βοήθειά τους.

Μετά την παρουσίαση του τροφοδοτούμενο από Α.Ι. Bing, η ομάδα δεοντολογίας κατέγραψε τις απαρασάλευτες ανησυχίες. Οι χρήστες θα μπορούσαν να καταλήξουν υπερβολικά εξαρτημένοι από το εργαλείο. Οι ανακριβείς απαντήσεις θα μπορούσαν να τους παραπλανήσουν χρήστες και κάποιοι θα μπορούσαν να πιστέψουν ότι το chatbot, το οποίο που μιλά σε πρώτο πρόσωπο και χρησιμοποιεί emojis, ήταν άνθρωπος.

Στα μέσα Μαρτίου, τα μέλη της ομάδας απολύθηκαν, ωστόσο εκατοντάδες υπάλληλοι εξακολουθούν να εργάζονται πάνω στα ζητήματα ηθικής.

Η Microsoft κυκλοφορεί νέα προϊόντα κάθε εβδομάδα, με έναν «ξέφρενο ρυθμό για να εκπληρώσει τους στόχους που έθεσε ο κ. Ναντέλα το καλοκαίρι, όταν έκανε προεπισκόπηση του νεότερου μοντέλου της OpenAI» γράφουν οι NYT..

Ζήτησε από το chatbot να μεταφράσει τον Πέρση ποιητή Τζελαλεντίν Ρουμι στα Ουρντού και στη συνέχεια να το γράψει με αγγλικούς χαρακτήρες. «Δούλεψε άψογα», δήλωσε σε συνέντευξή του τον Φεβρουάριο. «Τότε είπα, “Θεέ μου, τι είναι αυτό το πράγμα”».

Super League

Super League

Premier League

Premier League

Champions League

Champions League

Europa League

Europa League

UEFA Conference League

UEFA Conference League

Bundesliga

Bundesliga

Serie A

Serie A

La Liga

La Liga

Ligue 1

Ligue 1

Superleague 2

Superleague 2

Κύπελλο Ελλάδας

Κύπελλο Ελλάδας

Euroleague

Euroleague

Basket League

Basket League

NBA

NBA

Eurocup

Eurocup

Basketball Champions League

Basketball Champions League

Volley

Volley

Tennis

Tennis

Πόλο

Πόλο

Στίβος

Στίβος

Αυτοκίνητο

Αυτοκίνητο